一个功能健全的kafka集群可以处理相当大的数据量,由于消息系统是很多大型应用的基石,因此broker集群在性能上的缺陷,都会引起整个应用栈的各种问题。Kafka的度量指标主要有以下三类:1.Kafka服务器(Kafka)指标2.生产者指标3.消费者指标另外,由于Kafka的状态靠Zookeeper来维护,对于Zookeeper性能的监控也成为了整个Ka zz~~ 3年前 (2022-05-01) 1391℃ 0评论0喜欢

《Kafka: The Definitive Guide, 2nd Edition》于 2021年11月由 O'Reilly Media 出版, ISBN 为 9781492043089 ,全书 486 页。如果想及时了解Spark、Hadoop或者HBase相关的文章,欢迎关注微信公众号:iteblog_hadoop图书介绍Every enterprise application creates data, whether it consists of log messages, metrics, user activity, or outgoing messages. Moving all this data is just as important as the w397090770 3年前 (2022-03-22) 1235℃ 0评论4喜欢

《Kafka in Action》于 2022年01月由 Manning 出版, ISBN 为 9781617295232 ,全书 272 页。如果想及时了解Spark、Hadoop或者HBase相关的文章,欢迎关注微信公众号:iteblog_hadoop图书介绍作者有多年使用 Kafka 的真实世界的经验,这本书的实地感觉真的让它与众不同。---- From the foreword by Jun Rao, Confluent CofounderMaster the wicked-fast Apache Kafka streaming w397090770 3年前 (2022-03-02) 662℃ 0评论3喜欢

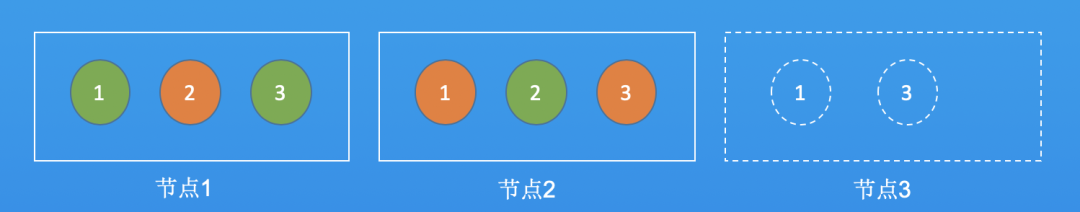

什么是数据迁移Apache Kafka 对于数据迁移的官方说法是分区重分配。即重新分配分区在集群的分布情况。官方提供了kafka-reassign-partitions.sh脚本来执行分区重分配操作。其底层实现主要有如下三步: 通过副本复制的机制将老节点上的分区搬迁到新的节点上。 然后再将Leader切换到新的节点。 最后删除老节点上的分区。重分 zz~~ 3年前 (2021-09-24) 947℃ 0评论5喜欢

Apache Kafka 3.0 于2021年9月21日正式发布。本文将介绍这个版本的新功能。以下文章翻译自 《What's New in Apache Kafka 3.0.0》。如果想及时了解Spark、Hadoop或者HBase相关的文章,欢迎关注微信公众号:过往记忆大数据我很高兴地代表 Apache Kafka® 社区宣布 Apache Kafka 3.0 的发布。 Apache Kafka 3.0 是一个大版本,其引入了各种新功能、API 发生重 w397090770 3年前 (2021-09-24) 630℃ 0评论2喜欢

Apache Kafka 是一个开源流处理平台,如今有超过30%的财富500强企业使用该平台。Kafka 有很多特性使其成为事件流平台(event streaming platform)的事实上的标准。在这篇博文中,我将介绍每个 Kafka 开发者都应该知道的五件事,这样在使用 Kafka 就可以避免很多问题。Tip #1 理解消息传递和持久性保证对于数据持久性(data durability), w397090770 4年前 (2021-04-18) 1064℃ 0评论4喜欢

Apache Kafka 的核心设计是日志(Log)—— 一个简单的数据结构,使用顺序操作。以日志为中心的设计带来了高效的磁盘缓冲和 CPU 缓存使用、预取、零拷贝数据传输和许多其他好处,从而使 Kafka 能够提供高效率和吞吐量的功能。对于那些刚接触 Kafka 的人来说,主题(topic)以及提交日志的底层实现通常是他们学习的第一件事。但 w397090770 4年前 (2021-04-11) 775℃ 0评论4喜欢

Apache Kafka 2.7.0 于2020年12月21日正式发布,这个版本是目前 Kafka 最新稳定版本,大家可以根据需要自行决定是否需要升级到次版本,关于各个版本升级到 Apache Kafka 2.7.0 请参见《Upgrading to 2.7.0 from any version 0.8.x through 2.6.x》。在这个版本中,社区仍然在推进从 Kafka 移除对 ZooKeeper 的依赖,比如这个版本在 KIP-497 里面添加了可以修改 IS w397090770 4年前 (2020-12-27) 714℃ 0评论1喜欢

前言当开发人员通过我们提供的 API 使用公开的 Twitter 数据时,他们需要可靠性、高效的性能以及稳定性。因此,在前一段时间,我们为 Account Activity API 启动了 Account Activity Replay API ,让开发人员将稳定性融入到他们的系统中。Account Activity Replay API 是一个数据恢复工具,它允许开发人员检索5天前的事件。并且提供了恢复由于各种 w397090770 4年前 (2020-12-17) 577℃ 0评论0喜欢

Apache Kafka 2.6.0 于2020年08月03日正式发布。在这个版本中,社区做了很多显著的性能改进,特别是当 Broker 有非常多的分区时。Broker 关闭性能得到了显著提高;当生产者使用压缩时,性能也得到了显著提高。ACL 使用的各个方面都有不同程度的提升,并且需要更少的内存。这个版本还增加了对 Java 14 的支持。在过去的几个版本中,社 w397090770 4年前 (2020-08-23) 920℃ 0评论0喜欢