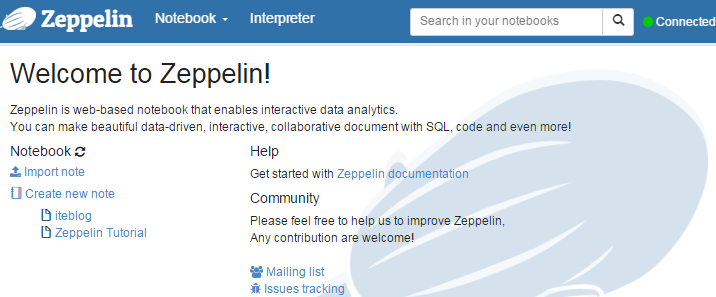

Apache Zeppelin 0.6.2发布。从上一个版本开始,Apache Zeppelin社区就在努力解决对Spark 2.0的支持以及一些Bug的修复。本次共有26位贡献者提供超过40多个补丁改进Apache Zeppelin和Bug修复。从Apache Zeppelin 0.6.1版本开始,编译的时候默认使用Scala 2.11。如果你想使用Scala 2.10来编译Apache Zeppelin,或者安装使用Scala 2.10编译的interpreter请参见官方文档。

Apache Zeppelin 0.6.2下载

改进

1、Spark interpreter同时支持Spark 1.6/Scala 2.10 和 Spark 2.0/Scala 2.11;

2、Note storage aware of user on sync

3、通过使用hadoop commons Credential apis 和 jceks提供shiro密码加密函数;

4、为ZeppelinHub添加新的 Shiro Realm;

5、Notebook versioning in ZeppelinHub Repo

修复

1、Spark 2.0.0中通过SPARK_SUBMIT_OPTIONS添加依赖无法正常工作;

2、在interpreter 中设置的环境变量不生效;

3、Fix UDF with Spark 2.0.0

4、z.show() doesn't work

5、SparkInterpreter在HDP 2.5的Spark2无法工作;

6、当SPARK_HOME没有设置时,使得%dep在spark 2.0.0正常工作;

7、Display long interger in abbreviated format on scatterChart/stackedAreaChart

8、The graph legend truncates at the nearest period(.) in its grouping

9、Lamda表达式在 CDH 5.7.x Spark中无法使用

已知的问题

在Zeppelin中R/SparkR interpreter有两种实现,通过-Pr构建的R interpreter尚未通过Spark 2.0测试;推荐R interpreter 的用户使用-Psparkr来构建Zeppelin。

本博客文章除特别声明,全部都是原创!原创文章版权归过往记忆大数据(过往记忆)所有,未经许可不得转载。

本文链接: 【Apache Zeppelin 0.6.2发布及其更新介绍】(https://www.iteblog.com/archives/1843.html)