1.文件大小默认为64M,改为128M有啥影响?

2.RPC的原理?

3.NameNode与SecondaryNameNode的区别与联系?

4.介绍MadpReduce整个过程,比如把WordCount的例子的细节将清楚(重点讲解Shuffle)?

5.MapReduce出现单点负载多大,怎么负载平衡?

6.MapReduce怎么实现Top10?

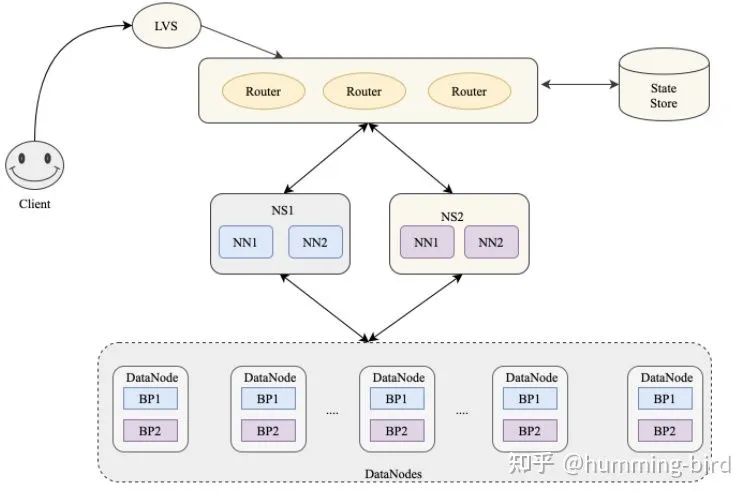

7.hadoop底层存储设计

8.zookeeper有什么优点,用在什么场合

9.Hbase中的metastore用来做什么的?

10.HBase在进行模型设计时重点在什么地方?一张表中国定义多少个Column Family最合适?为什么?

11.如何提高HBase客户端的读写性能?请举例说明。

12.在hadoop开发过程中使用过哪些算法?其应用场景是什么?

13.MapReduce程序如何发布?如果MapReduce中涉及到了第三方的jar 包,该如何处理?

14.在实际工作中使用过哪些集群的运维工具,请分别阐述其作用。

本博客文章除特别声明,全部都是原创!原创文章版权归过往记忆大数据(过往记忆)所有,未经许可不得转载。

本文链接: 【Hadoop面试题系列(4/11)】(https://www.iteblog.com/archives/1759.html)